OpenLiteSpeed: che cos’è, come funziona e perché è l’alternativa più veloce

Nel mondo Web & Hosting si parla spesso di Apache e Nginx, ma da qualche anno c’è un terzo nome che torna con insistenza ogni volta che si discute di prestazioni e WordPress. OpenLiteSpeed. Versione open source del server LiteSpeed, è diventato per molti provider e sysadmin l’alternativa più veloce quando si vogliono spremere al massimo siti dinamici senza stravolgere lo stack.

Basta dare un’occhiata alla documentazione ufficiale su openlitespeed.org per capire la filosofia del progetto. Server HTTP leggero, modello ad eventi, supporto nativo a HTTP 3 e QUIC, integrazione diretta con i linguaggi più usati sul web. L’obiettivo è chiaro, offrire un motore capace di gestire grandi volumi di traffico con latenze ridotte e un uso di risorse sorprendentemente contenuto.

Per chi viene da anni di Apache o Nginx, OpenLiteSpeed è un po’ come aprire il cofano di un motore moderno dopo aver guidato per anni la stessa auto affidabile ma un po’ stanca. Alcuni concetti restano familiari, altri chiedono di cambiare abitudini. Il risultato, se lo si sa sfruttare, è un salto di reattività che i visitatori percepiscono subito.

Che cos’è davvero OpenLiteSpeed

OpenLiteSpeed è un web server e reverse proxy open source sviluppato da LiteSpeed Technologies. Condivide con la versione commerciale LiteSpeed Web Server lo stesso cuore di elaborazione, ma si presenta con una licenza libera e alcune differenze nelle funzionalità avanzate. Per molti scenari, soprattutto nel mondo dei siti dinamici in PHP, rappresenta comunque un salto di qualità rispetto alle soluzioni tradizionali.

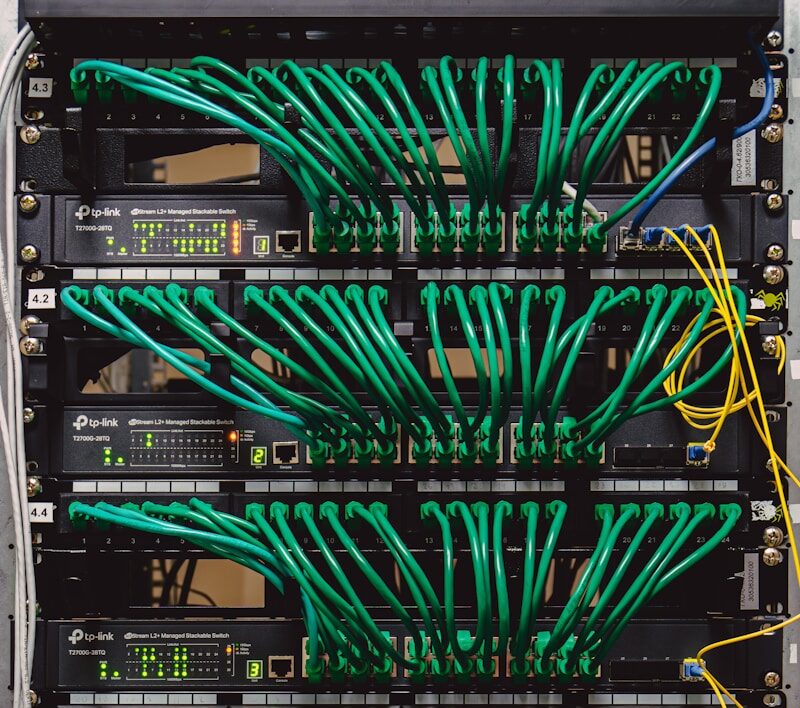

Il server è pensato per lavorare con un modello ad eventi, simile nell’idea a quello di Nginx, ma con un’attenzione particolare alla gestione di connessioni persistenti, cache e compressione. L’obiettivo è massimizzare il numero di richieste servite per secondo mantenendo basso il carico su CPU e memoria. In pratica, sopportare picchi di traffico con meno hardware.

Uno dei punti forti di OpenLiteSpeed è la sua integrazione con le applicazioni PHP tramite LSAPI, una interfaccia ottimizzata che riduce l’overhead rispetto a soluzioni come PHP FPM. Questo si nota in modo particolare con CMS come WordPress, dove ogni millisecondo risparmiato sulla generazione della pagina fa la differenza.

Come funziona nel mondo Web & Hosting

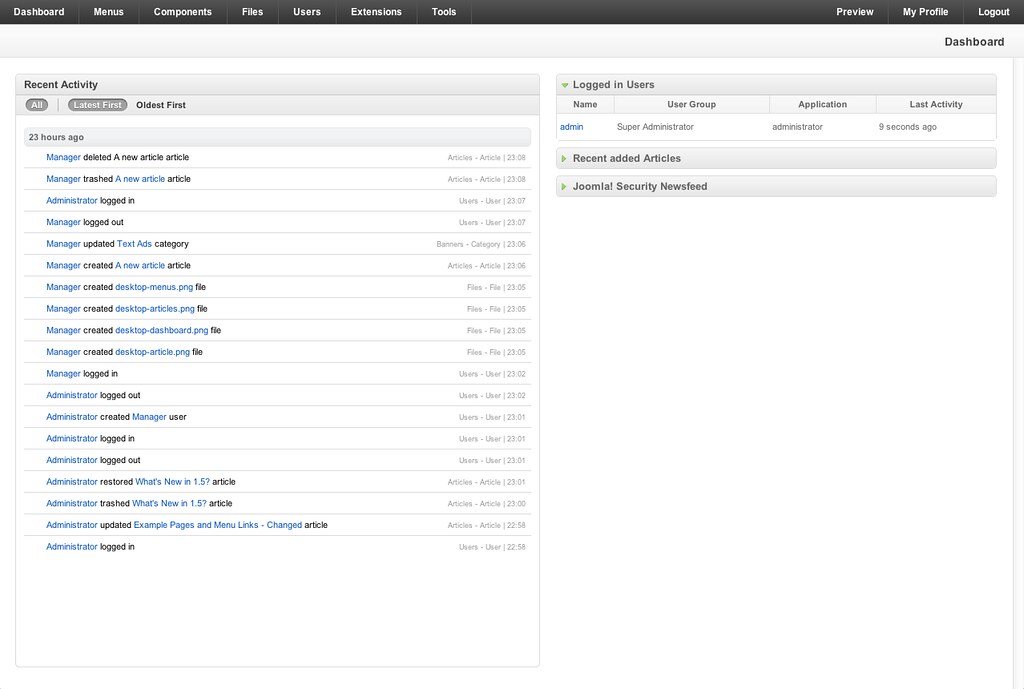

Dal punto di vista operativo OpenLiteSpeed si presenta con una dashboard di amministrazione accessibile via web, dove si configurano virtual host, listener, regole di riscrittura, certificati TLS e policy di cache. Per chi è abituato solo ai file di configurazione testuali la cosa può spiazzare, ma l’idea è rendere più immediata la gestione di scenari anche complessi.

I virtual host definiscono siti e applicazioni, un po’ come i vhost di Apache. Dentro ci vivono le impostazioni su document root, handler per PHP, regole di rewrite, log. OpenLiteSpeed supporta in buona parte la sintassi delle regole .htaccess, ma con una differenza importante. Le regole vengono lette e interpretate a livello di server, non a ogni richiesta, con un beneficio diretto sulle prestazioni. Non tutto ciò che si faceva in .htaccess è portabile uno a uno, ma la documentazione e vari esempi aiutano a gestire la transizione.

Sul fronte sicurezza e protocollo, OpenLiteSpeed offre supporto integrato a HTTP 2, HTTP 3 e QUIC, compressione Brotli, TLS moderno e controlli granolari su limiti di richiesta e connessioni. Chi vuole spingersi oltre può integrare moduli per WAF e protezione applicativa, oppure affidarsi a soluzioni esterne mantenendo OpenLiteSpeed come primo punto di contatto per il traffico.

Il capitolo più citato quando si parla di hosting è però la gestione della cache lato server. Con l’estensione LSCache e i plugin dedicati, per esempio quello ufficiale per WordPress documentato su wordpress.org, è possibile combinare caching aggressivo, ottimizzazione delle risorse statiche e regole di esclusione raffinate. Il risultato è che molte richieste vengono servite direttamente dalla cache di OpenLiteSpeed, alleggerendo enormemente il lavoro di PHP e del database.

Perché viene percepito come alternativa più veloce

Dire che OpenLiteSpeed è sempre più veloce di Apache o Nginx sarebbe una semplificazione. Le prestazioni reali dipendono da configurazione, carico, tipo di applicazione. Ma ci sono motivi concreti per cui tanti test comparativi mostrano vantaggi significativi, soprattutto in scenari WordPress e simili.

Il primo riguarda il modello interno di elaborazione. L’uso di un event loop efficiente, combinato con una gestione aggressiva di cache e connessioni persistenti, riduce la quantità di lavoro ridondante per ogni richiesta. Meno processi da creare, meno contesto da cambiare, meno attese inutili.

Il secondo punto è la profonda integrazione con LSCache. Invece di affidare tutto a plugin che lavorano a livello di applicazione, OpenLiteSpeed può servire pagine intere dalla cache del server con logica fine per utenti loggati, pagine riservate, parametri URL. Questo consente di mantenere dinamica l’esperienza dove serve e statica dove conviene, senza perdere coerenza.

Il terzo elemento è l’attenzione alla semplicità operativa. La combinazione tra interfaccia web, compatibilità con buona parte delle regole .htaccess e documentazione mirata ha reso piu facile il passaggio per provider e sysadmin. Non è una migrazione a costo zero, ma è meno traumatica di cambiare completamente paradigma.

Per chi gestisce Web & Hosting la domanda non è solo quanto è veloce un server in un benchmark isolato, ma come si comporta sotto traffico reale, con clienti che installano plugin di ogni tipo e aggiornano spesso. OpenLiteSpeed ha dimostrato in molti contesti di reggere bene questo caos controllato, offrendo margini di prestazione e di scalabilità che si traducono in meno problemi e più siti veloci a parità di infrastruttura.

In un panorama in cui ogni millisecondo di risposta conta, soprattutto su mobile, avere un motore come OpenLiteSpeed nello stack significa poter promettere non solo uptime, ma anche reattività. Non è l’unica strada possibile, ma è una delle più interessanti per chi vuole spingersi oltre i classici binari di Apache e Nginx senza rinunciare al controllo sull’infrastruttura.